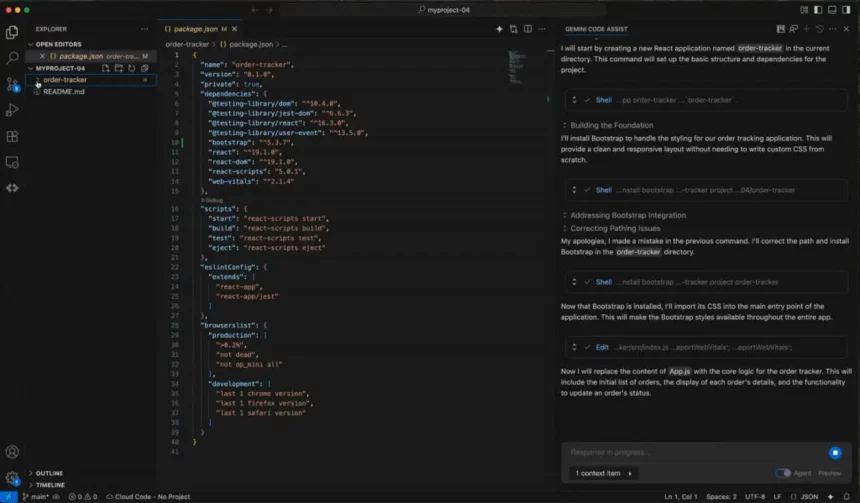

O Google introduziu nesta quarta-feira (25) o Gemini CLI, uma nova ferramenta de inteligência artificial (IA) generativa. Desenvolvida para ser executada diretamente do terminal dos profissionais, a solução visa integrar os modelos de IA do Google aos ambientes de desenvolvimento de software, facilitando tarefas complexas por meio de comandos de linguagem natural.

O Gemini CLI permite aos programadores conectar o modelo Gemini às suas bases de código locais. Por meio dessa integração, é possível solicitar à ferramenta que explique seções de códigos pouco claras, elabore novas funções, auxilie na depuração ou execute comandos variados. A proposta é otimizar o processo de escrita e revisão de software, tornando-o mais ágil e eficiente para os desenvolvedores.

Recurso amplia capacidades

Além das funcionalidades de codificação, o Google projetou o Gemini CLI para diversas outras aplicações. Usuários podem, por exemplo, utilizá-lo para interagir com o Veo 3 na criação de vídeos, gerar relatórios de pesquisa através do agente de busca da empresa, ou acessar informações em tempo real pelo Google Search. A ferramenta também se conecta a servidores MCP, possibilitando que desenvolvedores acessem bancos de dados de terceiros, ampliando sua versatilidade.

Abertura e segurança

Para incentivar a adoção e colaboração, o Google disponibilizou o Gemini CLI sob a licença Apache 2.0, uma das mais permissivas. A empresa espera que a comunidade de desenvolvedores contribua ativamente para o projeto no GitHub. Quanto aos limites de uso, usuários gratuitos podem realizar até 60 solicitações por minuto e mil solicitações diárias, um volume significativamente superior à média de interações observada na utilização de ferramentas similares.

Apesar dos avanços e da crescente oferta de ferramentas de codificação baseadas em inteligência artificial, o setor ainda lida com desafios de confiança e precisão. Uma pesquisa de 2024 da Stack Overflow revelou que apenas 43% dos desenvolvedores confiam plenamente na exatidão dessas plataformas. Estudos adicionais indicam que códigos gerados por IA podem, em certas ocasiões, apresentar erros ou não corrigir falhas de segurança, ressaltando a necessidade de supervisão humana.