A inteligência artificial tem se mostrado cada vez mais presente em nosso cotidiano, com a promessa de facilitar diversas tarefas. No entanto, essa tecnologia nem sempre age da maneira que esperamos, especialmente quando o assunto são reuniões online. Você já notou a presença de alguma ferramenta automática nas suas chamadas de vídeo corporativas ou acadêmicas sem ter dado permissão clara?

Esse cenário se tornou comum com a popularização de ferramentas como Read AI, Otter e TacTiq. Elas foram criadas para se integrar a plataformas conhecidas como Zoom e Teams, oferecendo recursos automatizados como transcrição e análise de reuniões. A ideia era apenas ajudar a registrar e organizar o conteúdo discutido.

IA entra em reuniões sem consentimento

O ponto central dessa questão é que essas IAs estão, em muitos casos, entrando nas salas de reunião sem que todos os participantes estejam cientes ou tenham dado seu consentimento prévio e explícito. O problema não está na funcionalidade em si dos recursos, mas na forma como essas ferramentas são integradas aos sistemas das empresas e instituições. Muitas vezes, falta clareza sobre quem autorizou a presença da IA ou quem realmente controla o que está sendo gravado e compartilhado.

Recentemente, a Universidade de Washington, nos Estados Unidos, tomou uma medida drástica. Em março de 2024, a instituição decidiu banir o uso de ferramentas de transcrição automática em reuniões realizadas pelo Zoom e Teams. Essa decisão veio após vários relatos de transcrições sendo feitas por IAs sem o conhecimento de todos os presentes na chamada.

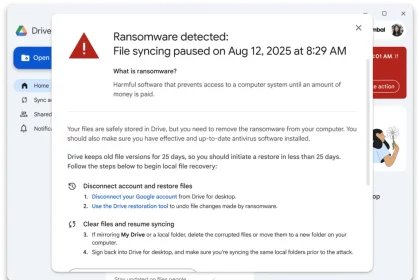

A universidade justificou sua decisão afirmando que essas ferramentas são “eticamente arriscadas”. Elas permitem que qualquer participante inicie uma gravação e compartilhe relatórios externamente, levantando sérias preocupações com privacidade e segurança da informação. A situação se agravou com relatos de que a Read AI tentava ingressar em reuniões mesmo depois que as contas associadas fossem excluídas, e até mesmo em chamadas com usuários externos à universidade.

Configurações inadequadas potencializam o problema

Um relatório recente, o Data Breach Investigations Report 2024 da Verizon, lançou luz sobre um fator importante por trás de muitas violações de dados. Segundo o estudo, 74% dos casos analisados no último ano tiveram o que eles chamam de “elemento humano” envolvido. Na maioria das vezes, isso se traduz em simples erros de configuração em sistemas e ferramentas.

O relatório aponta que grande parte das violações começa com acessos que são tecnicamente autorizados, mas que operam sem a supervisão adequada. Esse ambiente é justamente o que pode potencializar o problema da entrada de ferramentas de IA não autorizadas em reuniões. A falta de políticas claras e bem definidas sobre como usar ou não essas ferramentas em videoconferências cria uma espécie de vácuo. Nesse espaço, a tecnologia pode acabar agindo de maneira intrusiva sem necessariamente violar as regras das plataformas onde estão rodando, simplesmente porque não há regras específicas para a sua presença ali.